本地部署大模型知识库

本地部署大模型知识库

ollama 修改模型下载路径

Ollama 是一个开源项目,专注于在本地运行、创建和分享大型语言模型(LLMs)。它支持多种模型,包括 Llama 2、Code Llama 等,适用于文本生成、代码编写等任务。Ollama 提供命令行界面,便于用户与模型交互,并允许通过 API 进行集成。其核心优势在于本地运行,确保数据隐私和安全性。

下载默认位置

因为 Windows 安装下默认不支持修改程序安装目录,全部下载到 c 盘有点扛不住,简易修改到其他路径。

安装路径:C:\Users\username\AppData\Local\Programs\Ollama

模型路径:C:\Users\username\ .ollama

配置文件:C:\Users\username\AppData\Local\Ollama

修改模型路径

- 新建环境变量

OLLAMA_MODELS,值设置为其它任意路径。 - 重启电脑

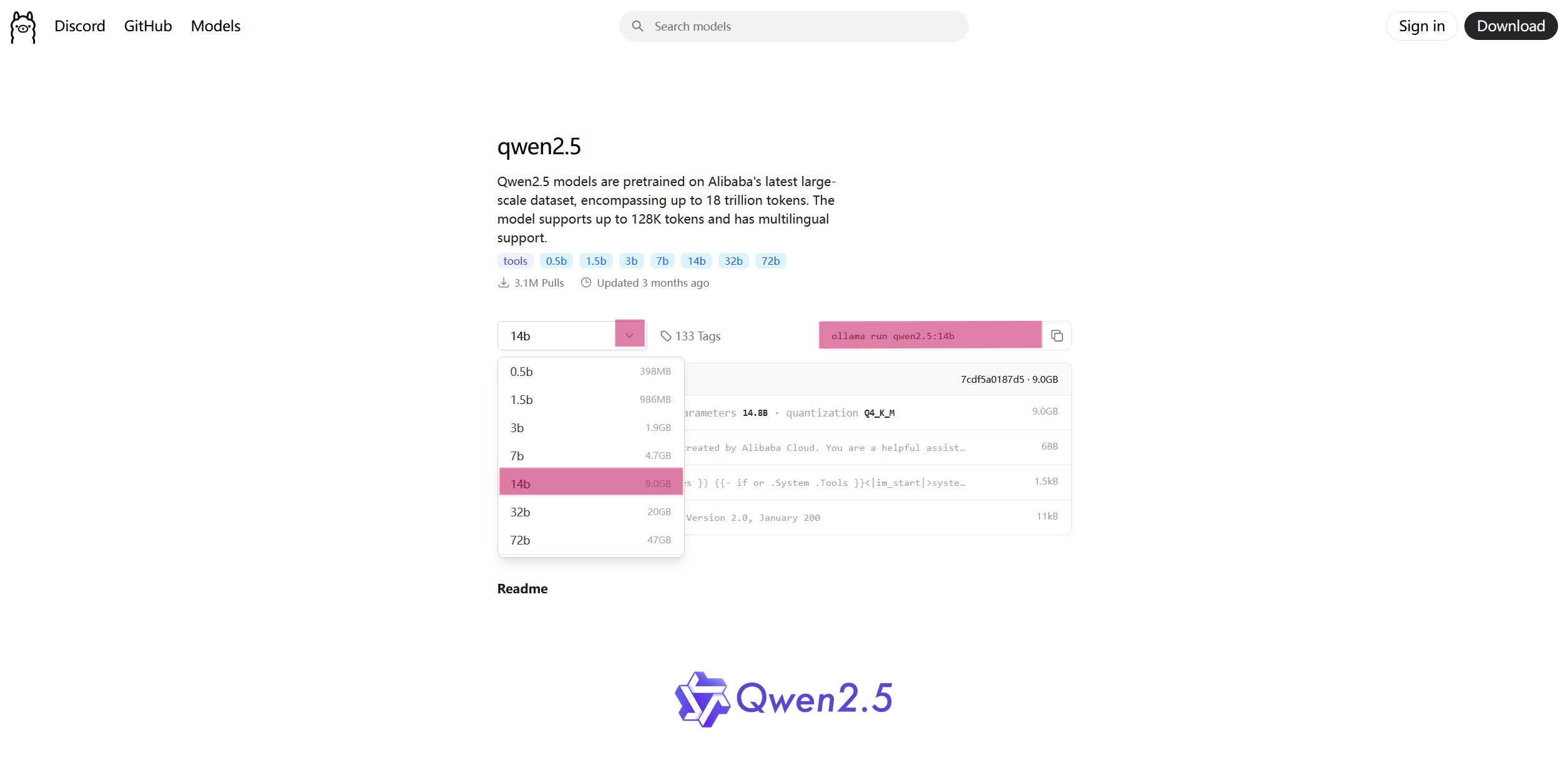

下载模型

打开cmd,在 ollama官网 查找需要下载的模型,以千问为例,选择适合自己设备的大模型和参数,复制右侧的命令ollama run qwen2.5:14b到 CMD 中,便会自动下载对应模型,下载完成后就可以在 CMD 窗口进行对话了。

Open-WebUi

已弃用

AnythingLLM

AnythingLLM 是采用 MIT 许可证的开源框架,支持快速在本地部署基于检索增强生成(RAG)的大模型应用。可以将任何文档、资源(如网址链接、音频、视频)或内容片段转换为上下文,以便任何大语言模型(LLM)在聊天期间作为参考使用。此应用程序允许您选择使用任意 LLM 或向量数据库,同时支持多用户管理并设置不同权限。能在不调用外部接口、不发送本地数据的情况下,确保用户数据的安全。

配置

开始可以随便填,保持默认选项点击下一步,后面随时可以进行修改。可以到左下角扳手标志处修改语言为中文。

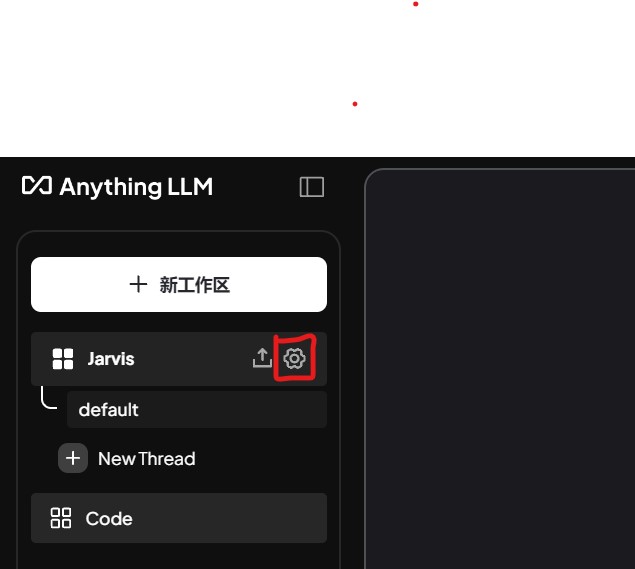

创建完工作区后点击如图齿轮标志。

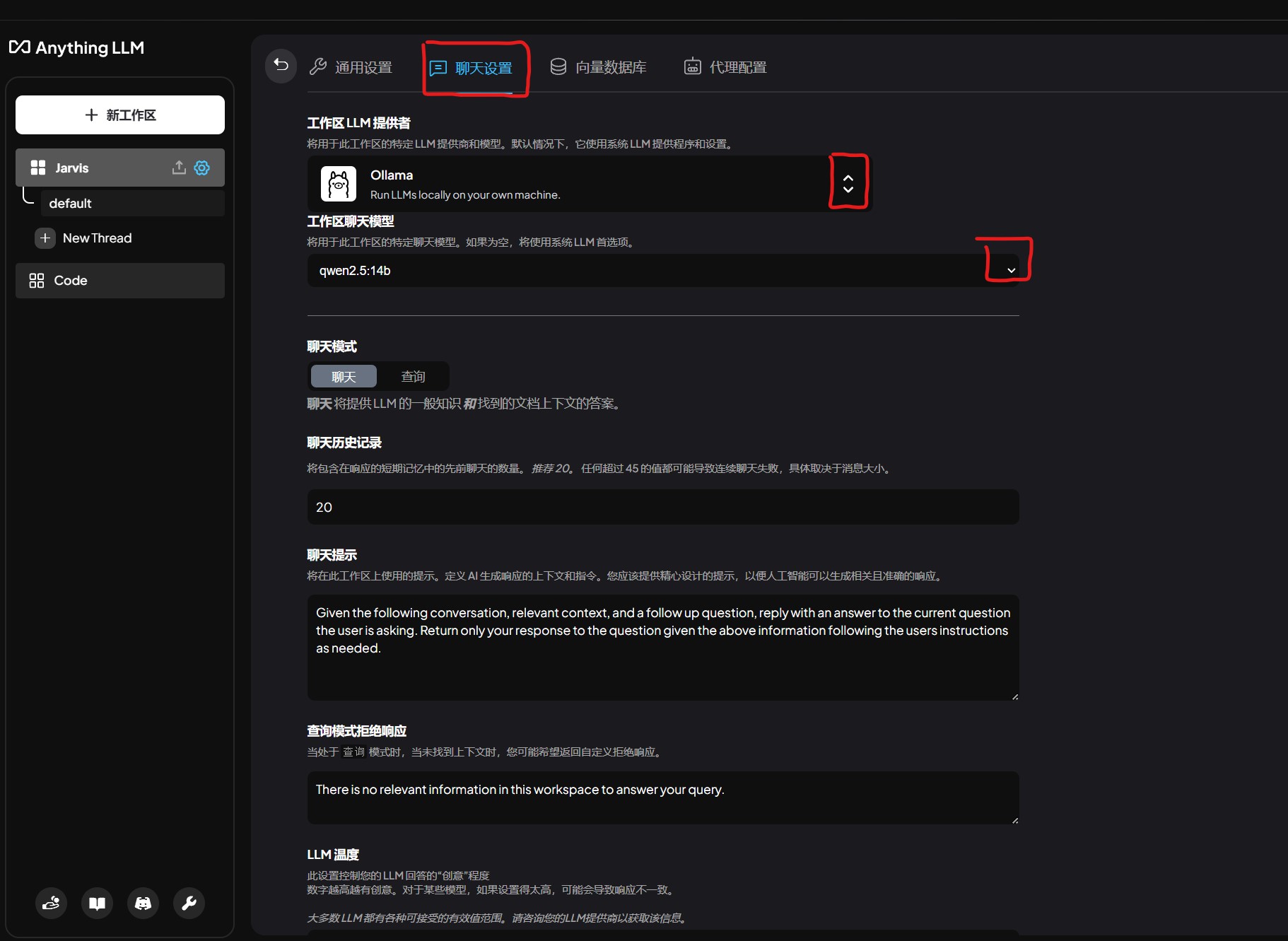

启动 ollama 服务,可以在聊天设置中的工作区 LLM 提供者找到 ollama,将工作区聊天模型设置为想要的模型,最后移到最下方点击 Update workspace。这样就能进行聊天了。

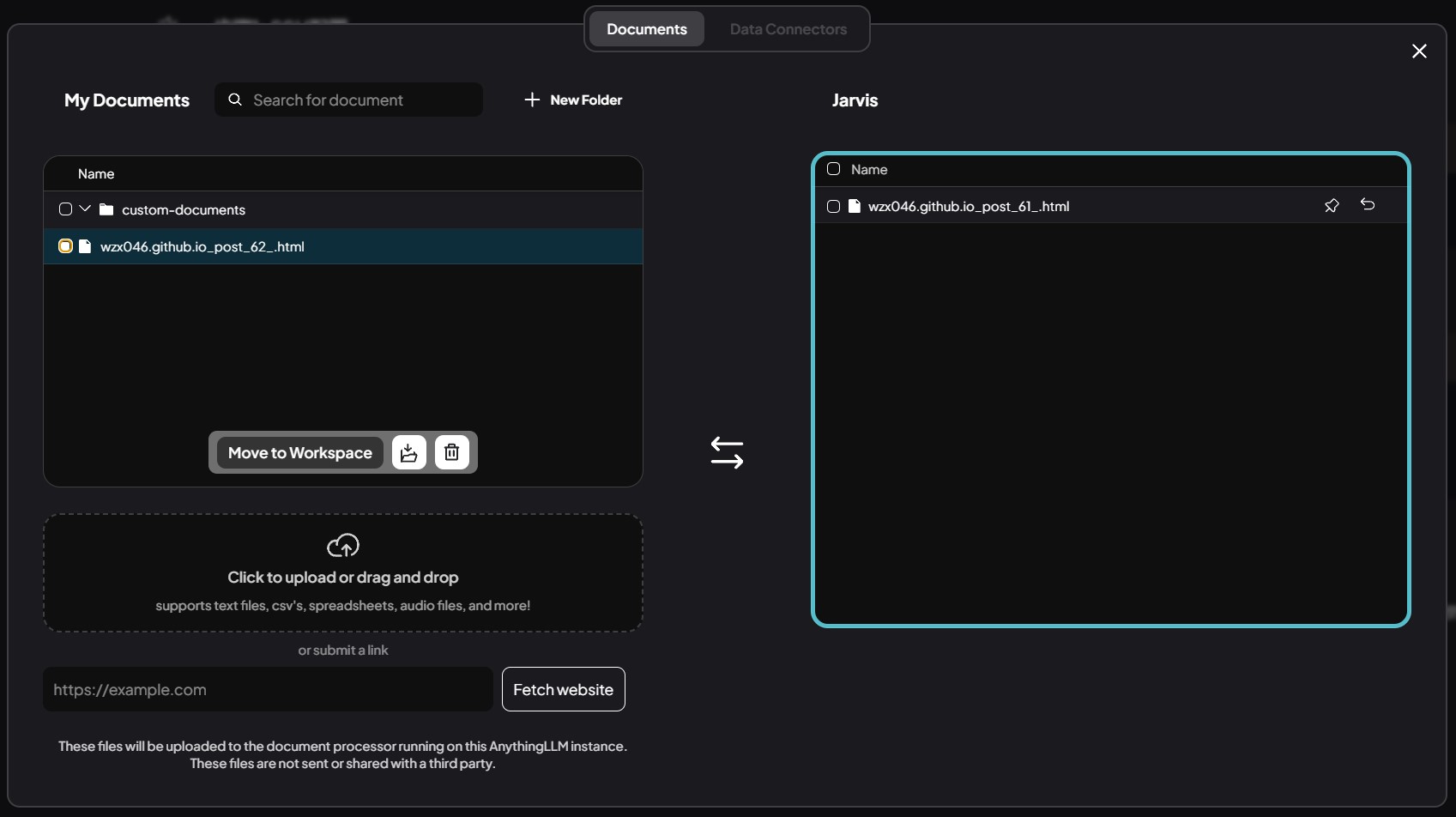

点击步骤一中齿轮标记左边的上传按键,点击虚线框可以上传文件,或者点击虚线框下面的文本框上传网址以搭建本地知识库。然后再将选中的文件

Move to Workspace,点击Save and Embed,本地知识库就搭建完成了。

测试

提问:SSH端口转发远程访问 Stable Diffusion的方案

回答:

可以看到,现在 AI 的回答引用了我的博客的内容并将网址显示在Citations中。

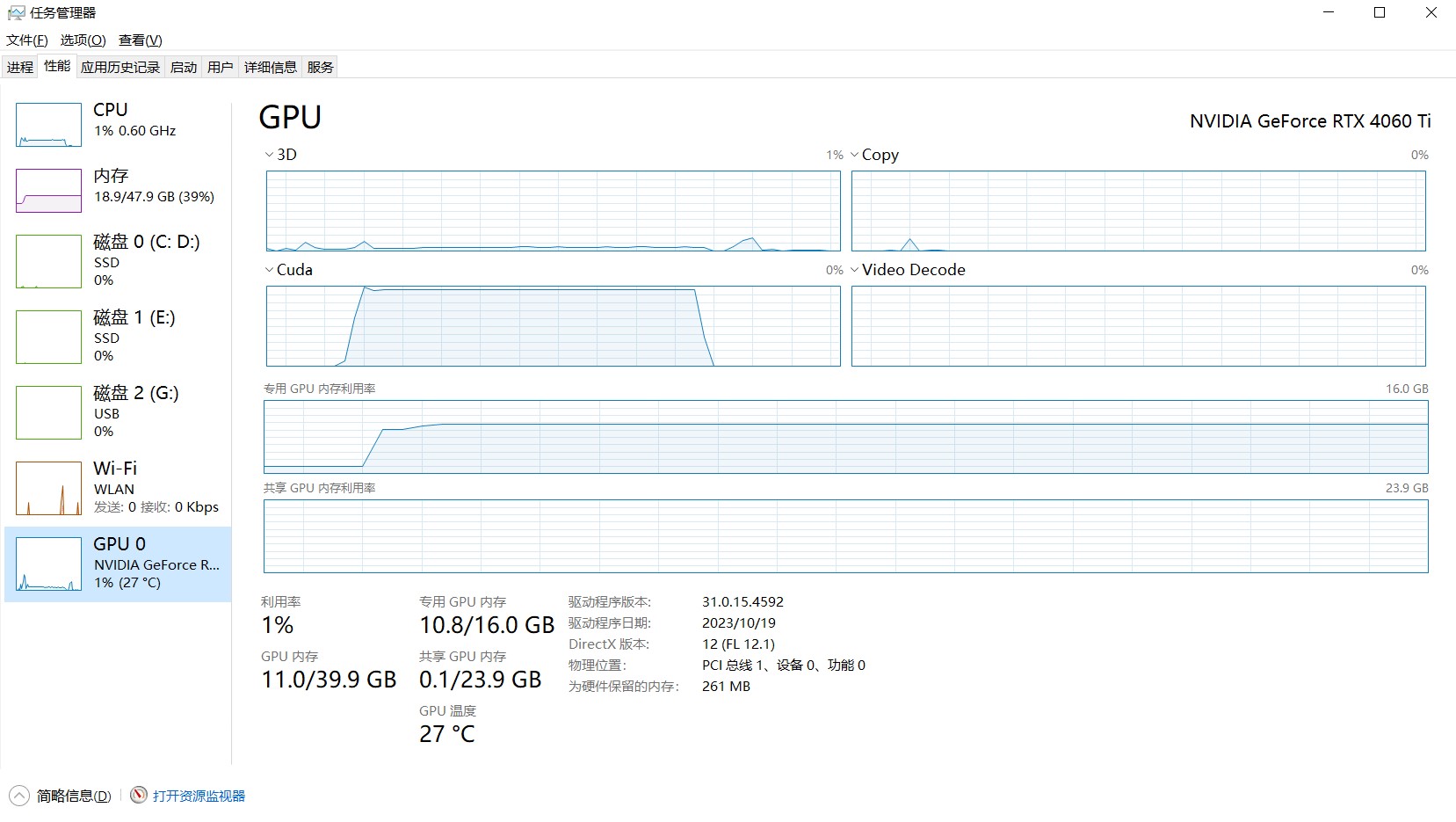

性能

qwen2.5:14b 的大小为 9GB,在运行过程中会消耗接近 10GB 内存和 10GB 显存,除了第一次加载模型或切换模型速度会慢点,正常使用时推理速度很快,回答质量也很不错,完全满足个人需求。